Cari cittadini e care cittadine, in questo 25 aprile, siamo qui per celebrare e ricordare la conquista della libertà da parte dell’Italia, con la fine dell'occupazione nazista e la definitiva caduta del regime fascista. Ringrazio per la presenza tutti voi e saluto...

È uno dei trend tecnologici degli ultimi anni: mettere alla prova le macchine nella creazione di opere d’arte fornendo loro tutte le regole e le istruzioni del mestiere. I risultati non sono stati mai entusiasmanti alla luce della meccanicità impressa su di una tela o di uno spartito, privi di quel tocco umano che è possibile definire genio. Lo staff del Laboratorio di Musica Elettronica del Conservatorio Duni e del collettivo di MaterElettrica, in collaborazione con il SisInfLab, Laboratorio di Sistemi Informativi del Politecnico di Bari (unico caso in Italia di collaborazione fra un’università e un conservatorio nell’ambito dell’intelligenza artificiale) hanno invece ribaltato il punto di vista provando a mettere le macchine al servizio del genio e della mente umana nel campo della musica, della composizione e dell’esecuzione live.

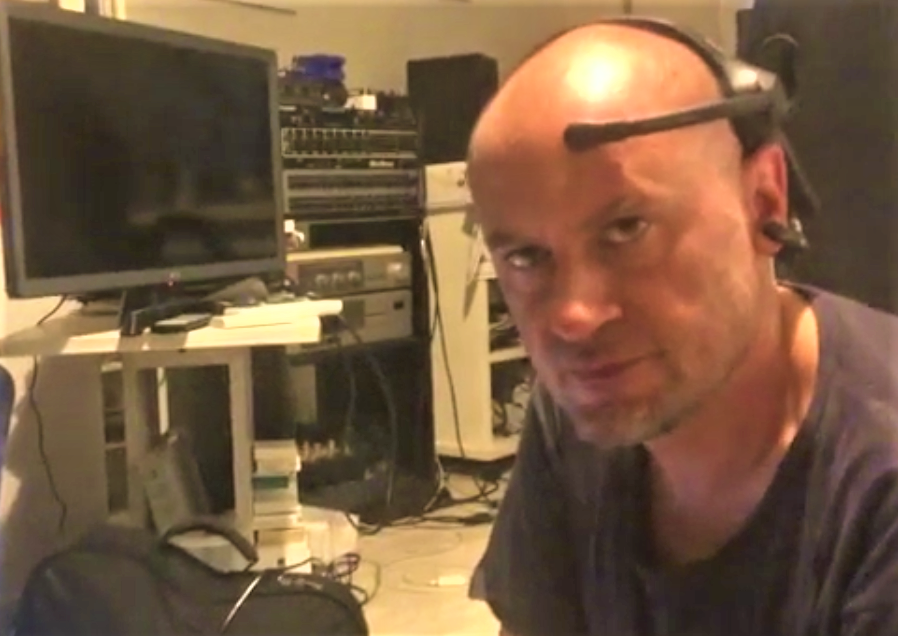

Giovedì 23 giugno alle ore 18, all’Auditorium Gervasio, nell’ambito della programmazione della Matera Digital Week, saranno così esposti i sorprendenti risultati, attraverso dimostrazioni dal vivo, delle ricerche nel campo dell’informatica musicale estesa alle applicazioni nello sconfinato universo dell’intelligenza artificiale: attraverso un dispositivo elettroencefalografico – una sorta di caschetto da indossare sulla testa – vengono infatti rilevati in tempo reale i tracciati EEG del musicista, che, in questo modo, durante l’esecuzione live con il proprio strumento, “controlla con la mente” il computer che produce dei suoni o altera il timbro dello strumento stesso, secondo la volontà dell’artista. Una specie di “duetto” uomo-macchina, dove però la macchina non è altro che un’estensione della mente umana in grado di tradurre in musica il pensiero e le emozioni del musicista, il quale non si avvale dei dispositivi tradizionali – come tastiere e controller – ma solo dell’elettroencefalografo che, collegato ad una rete neurale artificiale, è in grado di riconoscere gli stati mentali dell’artista.

La tecnologia impiegata si basa sull’unione dello studio di nuove forme di composizione assistita, con le esigenze contemporanee di interfacciare nuove modalità performative col riconoscimento emotivo. Si è quindi elaborato un sistema che permette, attraverso il dispositivo elettroencefalografico, il controllo di reti neurali specificatamente addestrate. Queste a loro volta agiscono sui parametri sonori in tempo reale, e consento di controllare strutture compositive attraverso la mente del compositore, con il supporto di reti di deep learning pre-addestrate. In altre parole, l’esecutore agisce durante la performance sui diversi elementi che costituiscono la performance stessa, il compositore può realizzare le sue idee musicali direttamente, interfacciandosi con il computer tramite appunto il dispositivo elettroencefalografico, quindi con la sola mente.

Del progetto e dei risultati ne parleranno Fabrizio Festa, docente presso il Conservatorio Duni di Matera, compositore e direttore d’orchestra che da molti anni si dedica alla ricerca nell’ambito dell’informatica musicale e delle neuroscienze, Tommaso Di Noia, docente di Intelligenza Artificiale presso il Politecnico di Bari, Tommaso Colafiglio – nella foto in copertina, ha conseguito un Master in Musica Elettronica e in Musica Applicata al Conservatorio Duni di Matera ed è attualmente vincitore di un assegno di ricerca presso il Politecnico di Bari, dove svolge attività di ricerca nel campo dell’Intelligenza Artificiale (rarissimo caso di uno diplomato di un’accademia che grazie agli studi di conservatorio accede a quelli di ingegneria).